Apple recientemente ha liberado STARFlow-V a la categoría de open source, un modelo de generación de vídeo por IA que rompe con todo lo establecido.

Hasta ahora, conocíamos otros LLMs como Sora, Veo 3 o Runway que usan usan modelos de difusión, Apple ha apostado por una tecnología diferente: los normalizing flows. Una arquitectura que la comunidad científica había descartado como «imposible de escalar» para vídeo… hasta ahora.

Un modelo presentado en junio y liberado recientemente

Así lo dio a conocer el equipo de investigación y desarrollo de Machine Learning de Apple:

Presentamos STARFlow, un modelo generativo escalable basado en flujos normalizadores que logra un excelente rendimiento en la síntesis de imágenes de alta resolución. El núcleo de STARFlow es el Flujo Autorregresivo de Transformadores (TARFlow), que combina la potencia expresiva de los flujos normalizadores con las capacidades de modelado estructurado de los Transformadores Autorregresivos.

Detrás de STARFlow, están: Jiatao Gu, Ying Shen, Tianrong Chen, Laurent Dinh, Yuyang Wang, Miguel Ángel Bautista, David Berthelot, Josh Susskind, Shuangfei Zhai

Cómo funciona STARFlow

En primer lugar, Apple estableció la universalidad teórica de TARFlow para modelar distribuciones continuas. Sobre esta base, introducieron varias innovaciones arquitectónicas y algorítmicas clave para mejorar significativamente la escalabilidad:

- (1) un diseño profundo-superficial, donde un bloque Transformador profundo captura la mayor parte de la capacidad de representación del modelo, complementado por algunos bloques Transformadores superficiales que son computacionalmente eficientes y, a la vez, sustancialmente beneficiosos;

- (2) modelado en el espacio latente de autocodificadores preentrenados, que resulta más efectivo que el modelado directo a nivel de píxel;

- (3) un novedoso algoritmo de guía que mejora significativamente la calidad de la muestra.

Fundamentalmente, el modelo de Apple sigue siendo un flujo normalizador de extremo a extremo, lo que permite un entrenamiento de máxima verosimilitud exacto en espacios continuos sin discretización. STARFlow alcanza un rendimiento competitivo en tareas de generación de imágenes tanto condicionales a la clase como al texto, acercándose a los modelos de difusión más avanzados en cuanto a calidad de muestra. Hasta donde sabemos, este trabajo es la primera demostración exitosa de flujos normalizadores que operan eficazmente a esta escala y resolución.

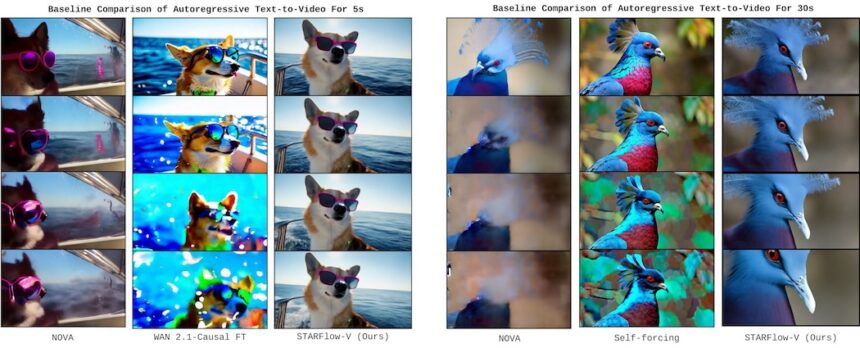

STARFlow-V es el primer basado en flujo normalizador generador de video causal que demuestra que los flujos normalizadores pueden coincidir con los modelos de difusión de video en calidad visual al tiempo que ofrece entrenamiento de extremo a extremo, estimación de probabilidad exacta y soporte multitarea nativo en la generación T2V/I2V/V2V.

Y aquí es donde llega una de esas pequeñas grandes cosas: STARFlow-V está entrenado en 70 millones de pares de texto-video y 400 millones de pares de texto-imagen.

Con un modelo final de parámetros 7B que puede generar video de 480p a 16 fps . El modelo opera en un espacio latente comprimido y aprovecha la naturaleza invertible de los flujos normalizadores. para soportar de forma nativa tareas de múltiples generaciones sin necesidad de cambios arquitectónicos ni reentrenamiento.

El trabajo futuro se centrará en cálculos más rápidos, variantes de modelo más pequeñas y datos de entrenamiento que prioricen la precisión física. Apple publica el código en GitHub, y los pesos del modelo se publicarán próximamente en Hugging Face.